Aprendizaje basado en árboles de decisión

Aprendizaje basado en árboles de decisión utiliza un árbol de decisión como un modelo predictivo que mapea observaciones sobre un artículo a conclusiones sobre el valor objetivo del artículo.

Los árboles de decisión se encuentran entre los algoritmos populares debido a su simplicidad.

[1][2] Aprendizaje basado en árboles de decisión es un método comúnmente utilizado en la minería de datos.

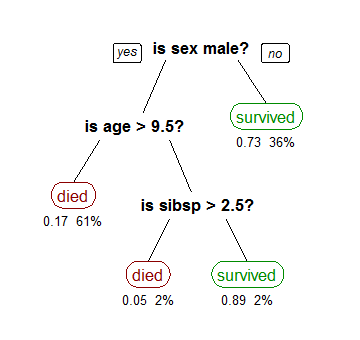

Un ejemplo se muestra a la derecha.

Un árbol de decisión es una representación simple para clasificar ejemplos.

Aprendizaje basado en árboles de decisión es una de las técnicas más eficaces para la clasificación supervisada[cita requerida].

Para esta sección, se supone que todas las funciones tienen dominios discretos finitos, y existe una sola característica de destino llamado la clasificación.

Cada elemento del dominio de la clasificación se llama clase.

Un árbol de decisión o un árbol de clasificación es un árbol en el que cada nodo interno (no hoja) está etiquetado con una función de entrada.

Un árbol puede ser "aprendido" mediante el fraccionamiento del conjunto inicial en subconjuntos basados en una prueba de valor de atributo.

Este proceso se repite en cada subconjunto derivado de una manera recursiva llamada particionamiento recursivo.

La recursividad termina cuando el subconjunto en un nodo tiene todo el mismo valor de la variable objetivo, o cuando la partición ya no agrega valor a las predicciones.

Los datos provienen en registros de la forma: La variable dependiente, Y, es la variable objetivo que estamos tratando de entender, clasificar o generalizar.

El vector x se compone de las variables de entrada, x1, x2, x3 etc., que se utilizan para esa tarea.

Los árboles de decisión utilizados en la minería de datos son de dos tipos principales: El término Árboles de Clasificación y Regresión (ACR) es un término genérico utilizado para referirse a ambos de los procedimientos anteriores, introducido por primera vez por Breiman et al.

Entre los más destacados están: ID3 y ACR se inventaron de forma independiente en la misma época (entre 1970 y 1980)[cita requerida], pero ambos siguen un enfoque similar para el aprendizaje basado en árboles de decisión a partir de tuplas de entrenamiento.

Algunos ejemplos se dan a continuación.

Estas métricas se aplican a cada subconjunto candidato, y los valores resultantes se combinan (por ejemplo, un promedio) para proporcionar una medida de la calidad de la división.

No debe confundirse con el coeficiente de Gini.

Alcanza su mínimo (cero) cuando todos los casos del nodo corresponden a una sola categoría de destino.

la fracción de artículos etiquetados con valor

debido a la partición en este nodo:

{\displaystyle I_{V}(N)={\frac {1}{|S|}}\sum _{i\in S}\sum _{j\in S}{\frac {1}{2}}(x_{i}-x_{j})^{2}-\left({\frac {1}{|S_{t}|}}\sum _{i\in S_{t}}\sum _{j\in S_{t}}{\frac {1}{2}}(x_{i}-x_{j})^{2}+{\frac {1}{|S_{f}|}}\sum _{i\in S_{f}}\sum _{j\in S_{f}}{\frac {1}{2}}(x_{i}-x_{j})^{2}\right)}

En un gráfico de decisiones, es posible utilizar disyunciones (OR) para unir dos caminos más utilizando la Longitud del mensaje Mínimo (MML).

[20] Los grafos de decisión se han ampliado para permitir nuevos atributos previamente no declarados que pueden ser aprendidos dinámicamente y utilizado en diferentes lugares dentro del grafo.

[21] Los esquemas de predicción más generales resultan en una mayor precisión predictiva y puntuación de la probabilidad log-pérdida.

[cita requerida] En general, los grafos de decisión infieren modelos con menos hojas que árboles de decisión x.

Los algoritmos evolutivos se han utilizado para evitar decisiones óptimas locales y buscar en el espacio del árbol de decisiones con poco un sesgo priori.

[22][23] También es posible para un árbol ser muestreado utilizando MCMC.

[24] El árbol puede ser recorrido de forma bottom-up.