Teorema de Gleason

Andrew M. Gleason demostró por primera vez el teorema en 1957,[1] respondiendo a una pregunta planteada por George W. Mackey, un logro que fue históricamente significativo por el papel que desempeñó al mostrar que amplias clases de teorías de variables ocultas son inconsistentes con la física cuántica.

En mecánica cuántica, cada sistema físico está asociado a un espacio de Hilbert.

En el enfoque codificado por John von Neumann, una medida sobre un sistema físico se representa mediante un operador autoadjunto en ese espacio de Hilbert, a veces denominado "observable".

La probabilidad de cualquier resultado de una medida en un sistema cuántico debe ser un número real entre 0 y 1 inclusive, y para ser consistente, para cualquier medida individual las probabilidades de los diferentes resultados posibles deben sumar 1.

Esto no sólo da la regla para calcular las probabilidades, sino que también determina el conjunto de posibles estados cuánticos.

Sin embargo, las suposiciones sobre las que von Neumann construyó su prueba de ausencia de variables ocultas eran bastante fuertes y finalmente se consideró que no estaban bien motivadas.

Su prueba fue ridiculizada por John Bell como "¡no sólo falsa, sino estúpida!".

[8][9] Gleason, por otro lado, no asumió la linealidad, sino simplemente la aditividad para los proyectores conmutativos junto con la no contextualidad, suposiciones consideradas mejor motivadas y más significativas físicamente.

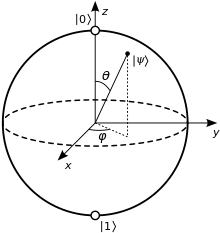

El resultado de Gleason implica que esto sólo ocurre en dimensión 2.

Una asignación de probabilidad no contextual como la definida en la sección anterior es equivalente a una función marco.

Gleason deduce una serie de lemas sobre cuándo una función marco es necesariamente regular, que culminan en el teorema final.

En primer lugar, establece que toda función marco continua en el espacio de Hilbert 𝑅3 es regular.

Este paso se considera el más difícil de la demostración[14] y, por último, demuestra que el problema general puede reducirse a este caso especial.

[15]: fn 3 Robin Lyth Hudson describió el teorema de Gleason como "célebre y notoriamente difícil"[16] Cooke, Keane y Moran produjeron posteriormente una demostración más larga que la de Gleason, pero que requiere menos prerrequisitos.

En consecuencia, la teoría cuántica es "un paquete más apretado de lo que uno podría haber pensado en un principio".

En una teoría determinista de variables ocultas, existe una propiedad física subyacente que fija el resultado encontrado en la medición.

Condicionado al valor de la propiedad física subyacente, cualquier resultado dado (por ejemplo, un resultado de +) debe ser imposible o estar garantizado.

Dado que esta esfera unitaria es conexa, ninguna medida de probabilidad continua sobre ella puede ser determinista.

Este tipo de dependencia a menudo se considera artificial o indeseable; en algunos casos, es incompatible con la relatividad especial.

Lo considera análogo a la forma en que la relatividad especial modifica la cinemática de la mecánica newtoniana.

Se organizan en un entramado, en el que la ley distributiva, válida en la lógica clásica, se debilita, para reflejar el hecho de que, en física cuántica, no todos los pares de magnitudes pueden medirse simultáneamente.

Gleason demostró originalmente el teorema suponiendo que las medidas aplicadas al sistema son del tipo von Neumann, es decir, que cada medida posible corresponde a una base ortonormal del espacio de Hilbert.

Posteriormente, Busch[32] e independientemente Caves et al: [17]: 116 [33] demostraron un resultado análogo para una clase más general de medidas, conocidas como medidas positivas-operador-valoradas (POVMs).